Was ist Netzwerksicherheit in der Cloud?

Die Netzwerksicherheit in der Cloud ist ein wichtiger Aspekt für den Schutz von containerisierten Anwendungen und deren Daten in der modernen Computing-Landschaft. Es geht darum, die Netzwerkkommunikation und die Konfigurationen für diese Anwendungen zu sichern, unabhängig von der Orchestrierungsplattform , die verwendet wird. Die Netzwerksicherheit in der Cloud befasst sich mit Netzwerksegmentierung, Namespaces, Overlay-Netzwerken, Verkehrsfilterung und Verschlüsselung für Container. Durch die Implementierung von Technologien und Best Practices für die Netzwerksicherheit in der Cloud können Organisationen effektiv netzwerkbasierte Angriffe wie Cryptojacking, Ransomware und BotNetC2 verhindern, die sich sowohl auf öffentliche Netzwerke als auch auf interne Netzwerke auswirken können, die von Containern zum Datenaustausch genutzt werden.

Netzwerksicherheit in der Cloud erklärt

Alle Workloads laufen auf demselben Netzwerk-Stack und denselben Protokollen, unabhängig davon, ob sie auf Bare-Metal-Servern, virtuellen Maschinen oder in Containern ausgeführt werden. Mit anderen Worten: Containerisierte Workloads sind vielen der gleichen netzwerkbasierten Angriffe ausgesetzt wie ältere Anwendungen - Cryptojacking, Ransomware, BotNetC2 und mehr.

Netzwerkbasierte Sicherheitsbedrohungen können sich jedoch auf zwei Arten auf Container auswirken - über öffentliche Netzwerke, die Anwendungen mit dem Internet verbinden, und über interne Netzwerke, die Kubernetes-Container für den Datenaustausch untereinander nutzen.

Die Netzwerksicherheit in der Cloud konzentriert sich auf die Sicherung der Netzwerkkommunikation und der Konfigurationen für containerisierte Anwendungen im Allgemeinen, unabhängig von der Orchestrierungsplattform. Es behandelt Aspekte wie Netzwerksegmentierung, Namespaces, Overlay-Netzwerke, Verkehrsfilterung und Verschlüsselung für Container.

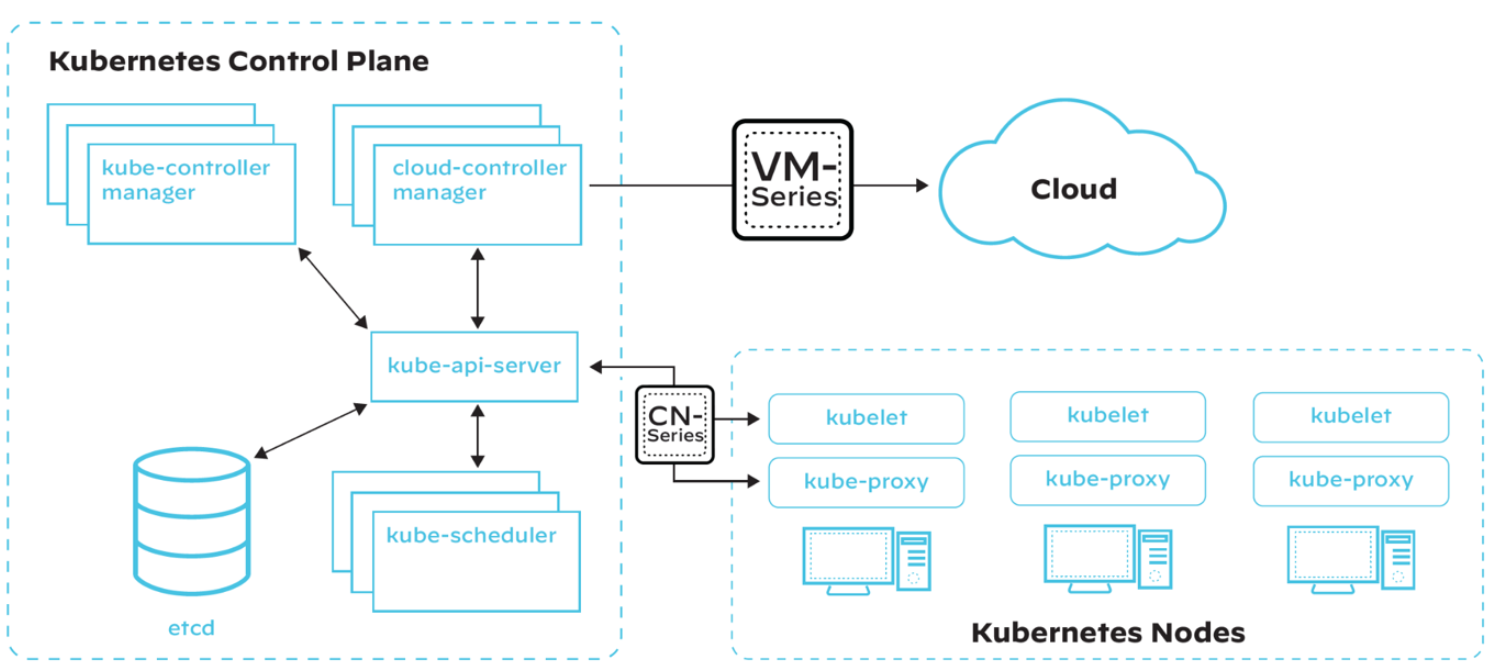

Kubernetes Netzwerksicherheit zielt auf die Netzwerksicherheit innerhalb eines Kubernetes-Clusters ab und umfasst Kubernetes-spezifische Funktionen wie Netzwerkrichtlinien, Ingress- und Egress-Kontrollen, Namespace-Isolierung, rollenbasierte Zugriffskontrolle (RBAC) und die Implementierung von Service Mesh.

Die Erkennung von Anzeichen bösartiger Aktivitäten in beiden Arten von Netzwerken erfordert sowohl Containersicherheit als auch Kubernetes Netzwerksicherheit. Da es sich hierbei um unterschiedliche Bereiche handelt, sollten sie separat diskutiert werden, um ihre einzigartigen Aspekte zu behandeln. In diesem Abschnitt befassen wir uns mit den verschiedenen Aspekten der Netzwerksicherheit in der Cloud im Zusammenhang mit Containern und erörtern bewährte Verfahren zum Schutz Ihrer Umgebung.

Netzwerksicherheit in der Cloud

Sobald sie bereitgestellt sind, müssen Container vor Versuchen geschützt werden, proprietäre Daten und Rechenressourcen zu stehlen. Die Netzwerksicherheit in der Cloud schränkt unerwünschte Kommunikation proaktiv ein und verhindert, dass Bedrohungen Ihre Anwendungen angreifen, sobald diese bereitgestellt wurden.

Containerisierte Next-Generation Firewalls, Webanwendungs- und API-Sicherheit (WAAS)und Mikrosegmentierung -Tools inspizieren und schützen den gesamten Datenverkehr, der in Container ein- und ausgeht (Nord-Süd und Ost-West), und gewähren vollständige Layer 7-Transparenzund Kontrolle über die Kubernetes-Umgebung. Darüber hinaus skalieren containerisierte Firewalls dynamisch mit der sich schnell ändernden Größe und den Anforderungen an die Container-Infrastruktur, um Sicherheit und Bandbreite für den Geschäftsbetrieb zu gewährleisten.

Netzwerk Segmentierung

Unter Netzwerksegmentierung versteht man die Aufteilung eines Netzwerks in kleinere, isolierte Segmente, um unbefugten Zugriff einzuschränken, potenzielle Bedrohungen einzudämmen und die Gesamtleistung des Netzwerks zu verbessern. In containerisierten Umgebungen können Sicherheitsteams die Segmentierung des Netzwerks durch eine Vielzahl von Methoden erreichen.

Netzwerk Namespaces

Netzwerk-Namensräume sorgen für die Isolierung zwischen Containern, indem sie für jeden Container einen eigenen Netzwerk-Stack erstellen, einschließlich eigener Netzwerkschnittstellen, Routing-Tabellen und Firewall-Regeln. Durch die Nutzung von Netzwerk-Namensräumen können Sie verhindern, dass sich Container gegenseitig in ihren Netzwerkkonfigurationen stören, und deren Sichtbarkeit auf die erforderlichen Netzwerkressourcen beschränken.

Overlay-Netzwerke

Overlay-Netzwerke schaffen eine virtuelle Netzwerkschicht über dem bestehenden physischen Netzwerk, die es Containern ermöglicht, über verschiedene Hosts hinweg so zu kommunizieren, als befänden sie sich im selben Netzwerk. Beliebte Lösungen für Overlay-Netzwerke für Container sind der integrierte Overlay-Treiber von Docker, Flannel und Weave.

Netzwerkpartitionen und Sicherheitsgruppen

Netzwerkpartitionen und Sicherheitsgruppen können Container-Netzwerke weiter segmentieren, indem sie logische Grenzen schaffen und spezifische Firewall-Regeln anwenden, um den Verkehr zwischen den Segmenten zu beschränken.

Verkehrsfilterung und Firewall-Regeln

Next-Generation Firewalls in Containern verhindern, dass Malware in den Cluster eindringt und sich dort ausbreitet. Gleichzeitig verhindern sie bösartige ausgehende Verbindungen, die für Datenexfiltration und Command-and-Control-Angriffe (C2) verwendet werden. Während Sicherheits-Tools von Shift-Links einen Schutz vor bekannten Schwachstellen bereitstellen, bieten Firewalls der nächsten Generation in Containern Schutz vor unbekannten und ungepatchten Schwachstellen.

Verkehrsfilterung und Firewall-Regeln sind für die Kontrolle des Datenverkehrs zwischen Containern sowie zwischen Containern und dem Hostunerlässlich.

Egress- und Ingress-Filterung

Die Egress-Filterung kontrolliert den von einem Container ausgehenden Verkehr, während die Ingress-Filterung den in einen Container eingehenden Verkehr kontrolliert. Durch die Anwendung von Egress- und Ingress-Filtern können Sie die Gefährdung Ihrer Container durch externe Bedrohungen begrenzen und ihre Kommunikation auf die notwendigen Dienste beschränken.

Anwendung von Firewall-Regeln auf den Containerverkehr

Firewall-Regeln können auf verschiedenen Ebenen angewendet werden, einschließlich der Host-, Container- und Netzwerkebene. Sie können z.B. Linux iptables oder firewalld verwenden, um Regeln für den Containerverkehr zu erstellen und Ihre Infrastruktur vor unbefugtem Zugriff und bösartigen Aktivitäten zu schützen.

Lastverteilung und Verkehrslenkung

Load Balancing und Traffic Routing sind wichtig, um den Datenverkehr auf mehrere Container zu verteilen und eine hohe Verfügbarkeit Ihrer Anwendungen zu gewährleisten. Lösungen wie HAProxy, NGINX oder die in Kubernetes integrierten Dienste können verwendet werden, um den Datenverkehr auf der Grundlage vordefinierter Regeln und Gesundheitsprüfungen an den entsprechenden Container weiterzuleiten.

Verschlüsselung und sichere Kommunikation

Die Verschlüsselung und Sicherung der Kommunikation zwischen Containern sowie zwischen Containern und dem Host ist für den Schutz sensibler Daten und die Aufrechterhaltung der Integrität Ihrer Anwendungen unerlässlich.

Transport Layer Security (TLS) für den Containerverkehr

TLS bietet Verschlüsselung und Authentifizierung für Daten, die über ein Netzwerk übertragen werden. Durch die Implementierung von TLS für den Container-Verkehr können Sie sicherstellen, dass die zwischen Containern und zwischen Containern und dem Host übertragenen Daten verschlüsselt und vor Abhören oder Manipulationen geschützt sind. Sie können dies erreichen, indem Sie Tools wie OpenSSL oder Let's Encrypt verwenden, um TLS-Zertifikate für Ihre Container zu erstellen und zu verwalten.

Sicherung der Container-zu-Container-Kommunikation

Um die Kommunikation zwischen Containern zu sichern, können Sie containereigene Lösungen wie die in Docker eingebauten verschlüsselten Netzwerke oder Tools von Drittanbietern wie Cilium verwenden, das API-fähige Netzwerksicherheit für Container bietet. Mit diesen Lösungen können Sie Verschlüsselung, Authentifizierung und Autorisierung für den Container-zu-Container-Verkehr implementieren.

Absicherung der Container-zu-Host-Kommunikation

Die Gewährleistung einer sicheren Kommunikation zwischen Containern und dem Host kann durch die Verwendung von Verschlüsselungs- und Authentifizierungsmechanismen auf Host-Ebene, wie SSH oder TLS-geschützte APIs, erreicht werden, um den Zugriff auf Container-Verwaltungsschnittstellen und Datenspeichersysteme zu kontrollieren.

Kubernetes Netzwerksicherheit

Netzwerk-Richtlinien

Netzwerkrichtlinien sind eine wichtige Funktion von Kubernetes, mit der Sie den Datenverkehr innerhalb Ihres Clusters und zwischen Ihrem Cluster und externen Netzwerken kontrollieren können. Moderne Tools ermöglichen es Sicherheitsteams, Richtlinien zu definieren, die im Wesentlichen festlegen, wer und was auf einen bestimmten Microservice zugreifen darf. Organisationen brauchen einen Rahmen, um diese Richtlinien zu definieren und sicherzustellen, dass sie in einer hochgradig verteilten Container-Anwendungsumgebung konsistent eingehalten werden.

Definieren und Durchsetzen von Netzwerkrichtlinien

Die Netzwerkrichtlinien von Kubernetes werden mithilfe von YAML-Dateien definiert, die den zulässigen Datenverkehr zwischen Komponenten wie Pods, Diensten und Namespaces festlegen. Sobald diese Richtlinien definiert sind, können sie mit Netzwerk-Plugins durchgesetzt werden, die die Kubernetes-API für Netzwerkrichtlinien unterstützen, wie z.B. Calico oder Cilium.

Whitelisting und Blacklisting von Datenverkehr

Netzwerkrichtlinien können verwendet werden, um den Datenverkehr zwischen den Komponenten Ihres Clusters auf der Grundlage von Kriterien wie Pod-Labels, IP-Adressen oder Namespaces auf eine Whitelist oder Blacklist zu setzen. So können Sie kontrollieren, welche Dienste miteinander kommunizieren können, und den unbefugten Zugriff auf sensible Daten oder Ressourcen verhindern.

Isolierung und Segmentierung von Namensräumen

Durch die Anwendung von Netzwerkrichtlinien auf Namensraumebene können Sie Anwendungen oder Umgebungen innerhalb Ihres Clusters isolieren und segmentieren, den Datenverkehr auf die notwendigen Komponenten beschränken und potenzielle Sicherheitsrisiken verhindern.

Zutritts- und Austrittskontrollen

Die Kontrolle des eingehenden und ausgehenden Datenverkehrs ist entscheidend für die Verwaltung des Datenflusses in und aus Ihrem Kubernetes-Cluster und den Schutz vor externen Bedrohungen.

Ingress-Controller und Lastausgleich

Ingress-Controller in Kubernetes verwalten das Routing des externen Datenverkehrs zu den entsprechenden Diensten innerhalb Ihres Clusters auf der Grundlage vordefinierter Regeln. Der Lastausgleich kann durch integrierte Kubernetes-Dienste oder Lösungen von Drittanbietern wie NGINX und HAProxy erreicht werden. Mit diesen Lösungen können Sie den Datenverkehr anhand von Kriterien wie Pfad, Host oder Header weiterleiten. Sie ermöglichen es Ihnen auch, TLS-Terminierung und andere Sicherheitsfunktionen bereitzustellen.

Bewährte Praktiken für den Ingress-Zugang

- Korrigieren Sie die standardmäßige "any-any-any allow"-Richtlinie von Kubernetes, indem Sie eine deny-all-Richtlinie für jeden Namespace anwenden.

- Verhindern Sie, dass Dienste eingehenden Datenverkehr direkt von externen IPs annehmen, es sei denn, es ist ein Load-Balancer oder Ingress angeschlossen. Lassen Sie nur eingehenden Verkehr von Load-Balancern oder Ingresses zu.

- Beschränken Sie den Datenverkehr auf bestimmte Protokolle und Ports entsprechend den Anforderungen des Dienstes (z.B. HTTP/HTTPS für Webdienste, UDP 53 für DNS-Dienste).

- Akzeptieren Sie nur Datenverkehr von anderen Diensten (Pods), die sie nutzen, sei es im gleichen oder in einem anderen Namespace.

- Um eine Ingress-Richtlinie von einem Pod in einem anderen Namespace zu erstellen, fügen Sie dem Namespace ein Label hinzu.

Verwaltung des Ausreiseverkehrs

Die Kontrolle des ausgehenden Datenverkehrs von Ihrem Kubernetes-Cluster ist unerlässlich, um Datenverluste zu verhindern und sicherzustellen, dass ausgehende Verbindungen nur auf die erforderlichen Ziele beschränkt sind. Dies können Sie mit Hilfe von Egress-Netzwerkrichtlinien erreichen, mit denen Sie Regeln für den von Ihren Pods oder Namespaces ausgehenden Datenverkehr festlegen können. Zusätzlich können Egress Gateways oder Proxy Lösungen wie Squid verwendet werden, um den ausgehenden Datenverkehr Ihres Clusters zu kontrollieren und zu überwachen.

Bewährte Praktiken für den Zugang zum Ausgang

- Verstehen Sie den Bedarf für jeden externen Dienst, der von Ihren Mikrodienstenverwendet wird. Produkte wie Prisma Cloud Compute Defender können dabei helfen, externe Ströme zu identifizieren, die von Microservices genutzt werden.

- Wenn ein Pod eine Verbindung zu einem DNS-Namen (FQDN) ohne feste IP-Adresse herstellen muss, verwenden Sie eine externe Firewall oder einen Proxy, da die Netzwerkrichtlinien von Kubernetes nur IP-Adressen unterstützen.

- Verhindern Sie ausgehenden Datenverkehr von Pods, die keine externen Verbindungen benötigen, um das Risiko der Datenexfiltration oder des Herunterladens bösartiger Binärdateien zu verringern.

- Wenden Sie eine Egress-Blockierungsrichtlinie an, wenn Sie keine externen Abhängigkeiten haben, aber sicherstellen, dass wichtige Dienste wie der Kubernetes DNS Service verbunden bleiben, wenn Sie Egress-Richtlinien durchsetzen.

Identitätsbasierte Mikrosegmentierung hilft, die Kommunikation zwischen Anwendungen auf Layer 3 und Layer 4 einzuschränken, während containerisierte Next-Gen-Firewalls eine Layer 7 Deep Packet Inspection durchführen und den gesamten erlaubten Datenverkehr scannen, um bekannte und unbekannte Bedrohungen zu identifizieren und zu verhindern.

DNS-Richtlinien und Sicherheit

DNS ist ein wesentlicher Bestandteil des Kubernetes-Netzwerks, da es die Namensauflösung für Dienste und andere Komponenten innerhalb Ihres Clusters bereitstellt. Stellen Sie die Sicherheit und Integrität Ihrer DNS-Infrastruktur sicher, um Angriffe wie DNS-Spoofing oder Cache Poisoningzu verhindern.

Kubernetes bietet integrierte DNS-Richtlinien zur Steuerung des Verhaltens der DNS-Auflösung innerhalb Ihres Clusters. Sie können auch externe DNS-Anbieter oder DNS-Sicherheitslösungen wie DNSSec verwenden, um die Sicherheit Ihrer DNS-Infrastruktur zu erhöhen.

Service Mesh und Netzwerk-Verschlüsselung

Service Mesh ist eine dedizierte Infrastrukturebene, die erweiterte Netzwerkfunktionen wie Traffic Routing, Lastausgleich und Sicherheit für Ihre Microservices und containerisierten Anwendungen bietet.

Implementierung von Service Mesh

Service-Mesh-Lösungen wie Istio und Linkerd können in Ihren Kubernetes-Cluster integriert werden, um erweiterte Netzwerkfunktionen bereitzustellen und die Sicherheit Ihrer containerisierten Anwendungen zu verbessern. Diese Lösungen bieten Funktionen wie gegenseitiges TLS, Zugriffskontrolle und Verkehrsverschlüsselung, mit denen Sie Ihre Anwendungen, insbesondere Microservices, vor verschiedenen Sicherheitsbedrohungen schützen können.

Mutual TLS (mTLS) für sichere Kommunikation

Mutual TLS (mTLS) ist ein Sicherheitsprotokoll, bei dem sowohl der Client als auch der Server die Identität des jeweils anderen authentifizieren, bevor sie eine sichere Verbindung herstellen. Im Gegensatz zum traditionellen TLS, bei dem nur der Server vom Client authentifiziert wird, fügt mTLS eine zusätzliche Sicherheitsebene hinzu, indem der Client ein Zertifikat vorlegen muss. Die zusätzliche Anforderung verifiziert, dass beide Parteien die sind, für die sie sich ausgeben, was dazu beitragen kann, unbefugten Zugriff, Datenverluste und Man-in-the-Middle-Angriffe zu verhindern.

Beobachtbarkeit und Kontrolle des Netzwerkverkehrs

Lösungen für Service Mesh bieten auch Beobachtbarkeit und Kontrolle über Ihren Netzwerkverkehr, so dass Sie die Leistung und Sicherheit Ihrer Anwendungen nahezu in Echtzeit überwachen können. Die frühzeitige Erkennung von unbefugtem Zugriff, ungewöhnlichen Datenverkehrsmustern und anderen potenziellen Sicherheitsproblemen bedeutet, dass Sie frühzeitig Korrekturmaßnahmen ergreifen können, um die Risiken zu mindern.

Verschlüsselung von Datenverkehr und sensiblen Daten

Um die Vertraulichkeit und Integrität von Daten innerhalb Ihres Clusters zu gewährleisten, ist die Implementierung von Verschlüsselungstechniken sowohl für die interne als auch für die externe Kommunikation unerlässlich.

IPsec zur Verschlüsselung der Kommunikation zwischen Hosts

IPsec schützt den Cluster-Datenverkehr, indem es die Kommunikation zwischen allen Master- und Knoten-Hosts verschlüsselt. Achten Sie auf den IPsec-Overhead und lesen Sie in der Dokumentation Ihrer Container-Orchestrierung nach, wie Sie die IPsec-Kommunikation innerhalb des Clusters aktivieren. Importieren Sie die erforderlichen Zertifikate in die entsprechende Zertifikatsdatenbank und erstellen Sie eine Richtlinie zur Sicherung der Kommunikation zwischen den Hosts in Ihrem Cluster.

Konfigurieren der maximalen Übertragungseinheit (MTU) für IPsec-Overhead

Passen Sie die MTU der Route oder des Switching an, um den IPsec-Header-Overhead zu berücksichtigen. Wenn der Cluster beispielsweise in einem Ethernet Netzwerk mit einer maximalen Übertragungseinheit (MTU) von 1500 Bytes arbeitet, ändern Sie den SDN MTU Wert, um den IPsec und SDN Encapsulation Overhead zu berücksichtigen.

Aktivieren von TLS für die API-Kommunikation im Cluster

Kubernetes geht davon aus, dass die API-Kommunikation innerhalb des Clusters standardmäßig mit TLS verschlüsselt wird. Die meisten Installationsmethoden erstellen und verteilen die erforderlichen Zertifikate an die Clusterkomponenten. Beachten Sie jedoch, dass einige Komponenten und Installationsmethoden lokale Ports über HTTP aktivieren können. Administratoren sollten über die Einstellungen der einzelnen Komponenten informiert sein, um potenziell unsicheren Datenverkehr zu erkennen und zu beseitigen.

Kubernetes Control Plane Sicherheit

Control Planes, insbesondere in Kubernetes-Clustern, sind bevorzugte Ziele für Angriffe. Um die Sicherheit zu erhöhen, härten Sie die folgenden Komponenten durch Inspektion und korrekte Konfiguration:

- Knoten und ihre Begrenzungen

- Master-Knoten

- Kernkomponenten

- APIs

- Öffentlich zugängliche Pods

Die Standardkonfiguration von Kubernetes bietet zwar ein gewisses Maß an Sicherheit, aber die Anwendung bewährter Praktiken kann den Cluster für Workloads und die Laufzeitkommunikation stärken.

Netzwerk-Richtlinien (Firewall-Regeln)

Das flache Netzwerk von Kubernetes ermöglicht es allen Bereitstellungen, andere Bereitstellungen standardmäßig zu erreichen, sogar über Namespaces hinweg. Diese fehlende Isolierung zwischen den Pods bedeutet, dass ein kompromittierter Workload einen Angriff auf andere Netzwerkkomponenten initiieren könnte. Die Implementierung von Netzwerk-Richtlinien kann für Isolation und Sicherheit sorgen.

Pod-Sicherheitspolitik

Kubernetes erlaubt es Pods, standardmäßig mit verschiedenen unsicheren Konfigurationen zu laufen. So ist beispielsweise die Ausführung von privilegierten Containern mit Root-Rechten auf dem Host ein hohes Risiko, ebenso wie die Verwendung der Namespaces und des Dateisystems des Hosts oder die gemeinsame Nutzung des Netzwerks des Hosts. Pod-Sicherheitsrichtlinien ermöglichen es Administratoren, die Privilegien und Berechtigungen eines Pods einzuschränken, bevor sie die Bereitstellung im Cluster erlauben. Die Isolierung von Pods, die nicht voneinander abhängig sind, mit Hilfe von Netzwerkrichtlinien verhindert im Falle eines Einbruchs laterale Bewegungen zwischen Containern.

Geheimnisse Verschlüsselung

Die Basisdistributionen von Kubernetes verschlüsseln standardmäßig keine Geheimnisse im Ruhezustand (obwohl verwaltete Dienste wie GKE dies tun). Wenn ein Angreifer Zugriff auf den Key-Value-Store (in der Regel Etcd) erhält, kann er auf alles im Cluster zugreifen, einschließlich unverschlüsselter Geheimnisse. Die Verschlüsselung des Cluster-Statusspeichers schützt den Cluster vor der Exfiltration von Daten im Ruhezustand.

Rollenbasierte Zugriffskontrolle

RBAC ist zwar nicht exklusiv für Kubernetes, aber es muss richtig konfiguriert werden, um eine Kompromittierung des Clusters zu verhindern. RBAC ermöglicht eine granulare Kontrolle über die Komponenten im Cluster, auf die ein Pod oder Benutzer zugreifen kann. Durch die Einschränkung, welche Benutzer und Pods innerhalb des Clusters angezeigt, aktualisiert, gelöscht und erstellt werden können, trägt RBAC zur Begrenzung des potenziellen Schadens einer Kompromittierung bei.

Sicherheit auf der Steuerungsebene durch virtuelles Patching

Die wichtigsten Sicherheitsgrundlagen sind die Minimierung des Zugriffs auf Steuerungsebenen auf Administratorenebene und die Gewährleistung, dass Ihr API-Server nicht öffentlich zugänglich ist.

DevOps und SecOps-Teams können Schwachstellen in Anwendungspaketen identifizieren, aber die Minderung dieser Risiken braucht Zeit. Anfällige Pakete müssen vor der Bereitstellung ersetzt oder gepatcht und getestet werden, wodurch die Umgebung bis zur Behebung des Problems ungeschützt bleibt. Lösungen wie Prisma Cloud automatisieren die Zuordnung von Schwachstellen zu den einzelnen Workloads, um virtuelles Patching für bekannte Schwachstellen bereitzustellen. Mithilfe der WAAS -Komponente passt die Lösung die Richtlinien zur Überprüfung des Datenverkehrs an, um HTTP-basierte Exploits zu erkennen und zu blockieren.

Bewährte Praktiken für die Netzwerksicherheit von Containern und Kubernetes

Als Zusammenfassung der besprochenen Bereiche dienen die folgenden Best Practices als Checkliste, um sicherzustellen, dass Ihre Teams für den Schutz Ihrer containerisierten Anwendungen und Daten vor netzwerkbasierten Bedrohungen gerüstet sind.

Überwachung und Protokollierung des Netzwerkverkehrs

Die genaue Überwachung Ihres Netzwerks ist von entscheidender Bedeutung für die Erkennung von und Reaktion auf Sicherheitsvorfälle und die Aufrechterhaltung des allgemeinen Zustands Ihrer containerisierten Umgebung.

Zentralisierte Lösungen für Protokollierung und Überwachung

Die Implementierung einer zentralen Protokollierungs- und Überwachungslösung für Ihre Container- und Kubernetes-Umgebung, wie z.B. ELK Stack, Prometheus oder Prisma Cloud, kann Ihnen helfen, Daten zum Netzwerkverkehr aus einer Vielzahl von Bereichen zu sammeln, zu analysieren und zu visualisieren. Der einfache Zugriff auf zentralisierte Daten ermöglicht es Ihnen, Trends zu erkennen, Anomalien zu entdecken und Einblicke in die Leistung und Sicherheit Ihrer Infrastruktur zu gewinnen.

Erkennen von und Reagieren auf Sicherheitsvorfälle

Die Überwachung des Netzwerkverkehrs und die Einrichtung von Warnmeldungen bei ungewöhnlichen oder verdächtigen Aktivitäten ermöglicht eine schnelle Erkennung von und Reaktion auf Vorfälle mit unberechtigtem Zugriff, Datenexfiltration und anderen bösartigen Aktivitäten. Die Sicherheitsteams sind in der Lage, geeignete Maßnahmen zu ergreifen, z.B. betroffene Komponenten zu isolieren, bösartige IPs zu blockieren oder Firewall-Regeln rechtzeitig zu aktualisieren.

Visualisierung und Analyse des Netzwerkverkehrs

Die Visualisierung und Analyse Ihres Netzwerkverkehrs kann Ihnen helfen, Muster und Trends zu erkennen, die auf potenzielle Sicherheitsrisiken hinweisen können. Mit Tools wie Kibana, Grafana oder benutzerdefinierten Dashboards können Sie visuelle Darstellungen Ihres Netzwerkverkehrs erstellen, mit denen Sie Anomalien erkennen und Sicherheitsvorfälle effektiver untersuchen können.

Sichere Netzwerk-Konfigurationen

Um Ihre Container- und Kubernetes-Umgebung vor Sicherheitsbedrohungen zu schützen, müssen Sie Ihre Netzwerkkonfigurationen härten und starke Zugriffskontrollen implementieren.

Härten der Host- und Cloud-Netzwerkeinstellungen

Um die Sicherheit Ihrer Umgebung aufrechtzuerhalten, müssen Sie sichere Netzwerk-Konfigurationen sowohl für Ihren Container-Host als auch für einzelne Container gewährleisten. Zu den wesentlichen Maßnahmen gehören die Deaktivierung ungenutzter Netzwerkdienste, die Beschränkung des Netzwerkzugriffs auf die notwendigen Komponenten und die Anwendung von Sicherheits-Patches und Updates für Ihr Host-Betriebssystem und die Container-Laufzeit.

Netzwerk-Zugangskontrollen und Authentifizierung

Um unbefugten Zugriff zu verhindern und die Integrität Ihrer Container- und Kubernetes-Umgebung aufrechtzuerhalten, ist es unerlässlich, starke Zugriffskontrollen und Authentifizierungsmechanismen zu implementieren. Zu den wichtigsten Maßnahmen gehören die Verwendung der rollenbasierten Zugriffskontrolle (RBAC) für die Verwaltung von Benutzerrechten in Kubernetes, die Multifaktor-Authentifizierung (MFA) und der Einsatz von Lösungen für die Netzwerksicherheit, wie VPNs oder Firewalls, um den Zugriff auf Ihre Umgebung zu beschränken.

Regelmäßige Überprüfungen der Netzwerksicherheit

Regelmäßige Bewertungen der Netzwerksicherheit - Schwachstellenscans, Penetrationstests und Sicherheitsaudits - sind ein Muss, wenn es darum geht, potenzielle Schwachstellen in Ihrer Container- und Kubernetes-Umgebung zu identifizieren. Zu den wichtigsten Aspekten dieser Bewertungen gehört die Prüfung von Netzwerkkonfigurationen, Firewall-Regeln und Sicherheitsrichtlinien, um die Einhaltung der branchenüblichen Best Practices und der Compliance-Anforderungen sicherzustellen.

Wenn Sie diese Best Practices befolgen und effektive Maßnahmen zur Netzwerksicherheit implementieren, können Sie Ihre Container- und Kubernetes-Umgebung vor potenziellen netzwerkbasierten Bedrohungen schützen und die Sicherheit und Integrität Ihrer Anwendungen und Daten gewährleisten.

FAQs zur Netzwerksicherheit in der Cloud

MTU (Maximum Transmission Unit) bezeichnet die größte Größe eines Datenpakets, das über ein Netzwerk übertragen werden kann. Sie ist ein entscheidender Parameter für die Effizienz und Leistung der Datenkommunikation in Netzwerken. Das Transmission Control Protocol (TCP) verwendet die MTU, um die maximale Größe der einzelnen Pakete bei Internetübertragungen zu bestimmen.

Um den zusätzlichen Header-Overhead unterzubringen, der durch die Verschlüsselung und Kapselung entsteht, müssen Sie den MTU-Wert anpassen, wenn Sie IPsec für die sichere Kommunikation verwenden. Wenn der Kubernetes-Cluster beispielsweise in einem Ethernet-Netzwerk mit einer Standard-MTU von 1500 Byte betrieben wird, sollte der MTU-Wert reduziert werden, um den Overhead bei der IPsec- und SDN-Kapselung zu berücksichtigen. Die Anpassung verhindert die Fragmentierung von Paketen und sorgt für eine effizientere und sichere Datenübertragung.